Claire contemplait la ville depuis la fenêtre de la salle de réunion, son café à la main. Quelques mois plus tôt, elle regardait l'Intelligence Artificielle comme une montagne infranchissable. Aujourd'hui, elle avait non seulement gravi le sommet, mais elle y avait planté son drapeau.

Ses projets pilotes étaient des succès : son chatbot RH ne "hallucinait" plus grâce à l'ancrage, et ses données étaient protégées dans la forteresse sécurisée qu'elle avait bâtie. Elle était devenue la Generative AI Leader incontestée.

Pourtant, ce matin-là, face à la feuille de route pour l'année prochaine, un nouveau vertige la saisit. Ce n'était plus le vertige de l'ignorance, mais celui du chaos.

Le casse-tête du "Landscape"

Le succès de ses premières initiatives avait créé un appel d'air. Désormais, chaque département voulait "son IA", et les demandes partaient dans tous les sens, créant une cacophonie technologique.

D'un côté, le directeur marketing voulait générer des vidéos promotionnelles en masse. De l'autre, le responsable de la maintenance se plaignait : "Claire, ton IA est géniale, mais mes techniciens travaillent dans des tunnels sans 4G. Ton chatbot dans le Cloud, il ne leur sert à rien."

En réunion budgétaire, le Directeur Financier, lui, pointait une ligne de coûts en rouge vif : "On paie pour des serveurs surpuissants pour des tâches simples. C'est comme louer un avion de chasse pour aller acheter du pain."

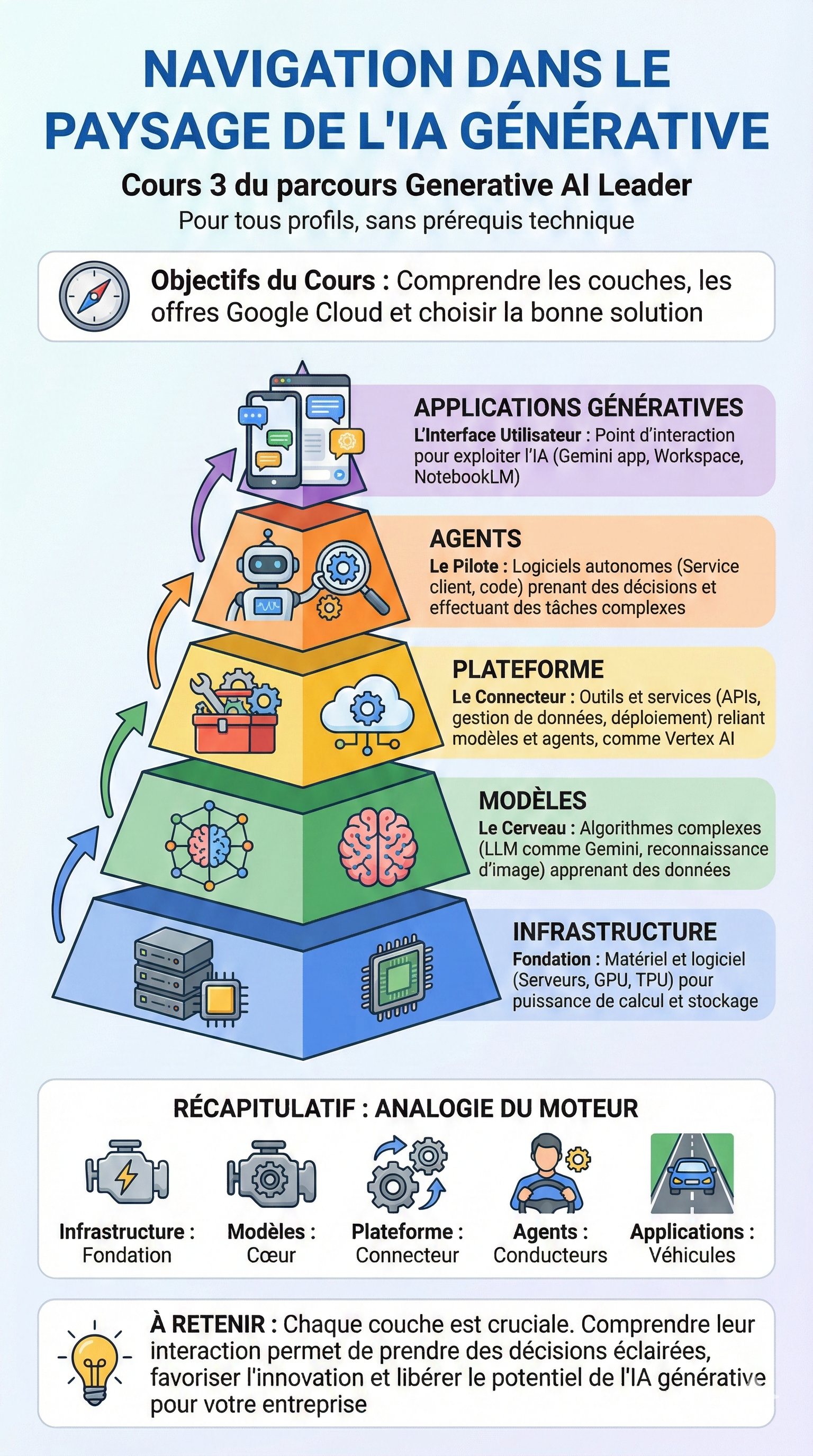

Claire réalisa qu'elle avait appris à piloter la voiture (l'usage), mais qu'on lui demandait désormais de dessiner le plan de circulation de toute la ville. Elle devait comprendre ce que sa formation appelait "Navigate the Landscape" (Naviguer dans le Paysage).

Ce terme, un peu abstrait au début, prit soudain tout son sens. L'IA n'était pas un bloc unique. C'était un vaste territoire avec ses autoroutes, ses usines et ses petits sentiers. Pour diriger, elle ne pouvait plus se contenter de connaître les outils ; elle devait maîtriser la cartographie complète de cet écosystème.

Quand le Cloud ne suffit plus : La révélation de l'Edge

La remarque du responsable maintenance l'obsédait. Comment amener l'intelligence artificielle là où internet n'existe pas ?

En creusant le sujet, Claire découvrit une partie du paysage qu'elle avait ignorée : l'Edge (la Périphérie).

Elle visualisa le concept ainsi : jusqu'à présent, elle utilisait le "Cloud", un cerveau géant et surpuissant situé à des milliers de kilomètres, à qui l'on envoyait des questions via internet. Mais pour ses techniciens dans les tunnels, c'était impossible.

L'Edge, comprit-elle, c'était l'inverse. C'était la capacité de prendre un petit morceau de ce cerveau et de l'installer directement dans l'appareil du technicien, sur son téléphone ou sa tablette. Plus besoin d'envoyer la donnée au loin. L'intelligence était locale, immédiate, "au bord" (at the edge) de l'action. C'était la solution pour réconcilier la puissance de l'IA avec la réalité du terrain.

Les couches géologiques de l'IA

De retour à son bureau, Claire effaça son tableau blanc. Pour répondre au Directeur Financier et rationaliser les coûts, elle devait déconstruire l'IA. Elle ne voyait plus "un outil", mais un empilement de couches, comme un mille-feuille, qu'elle devait assembler intelligemment :

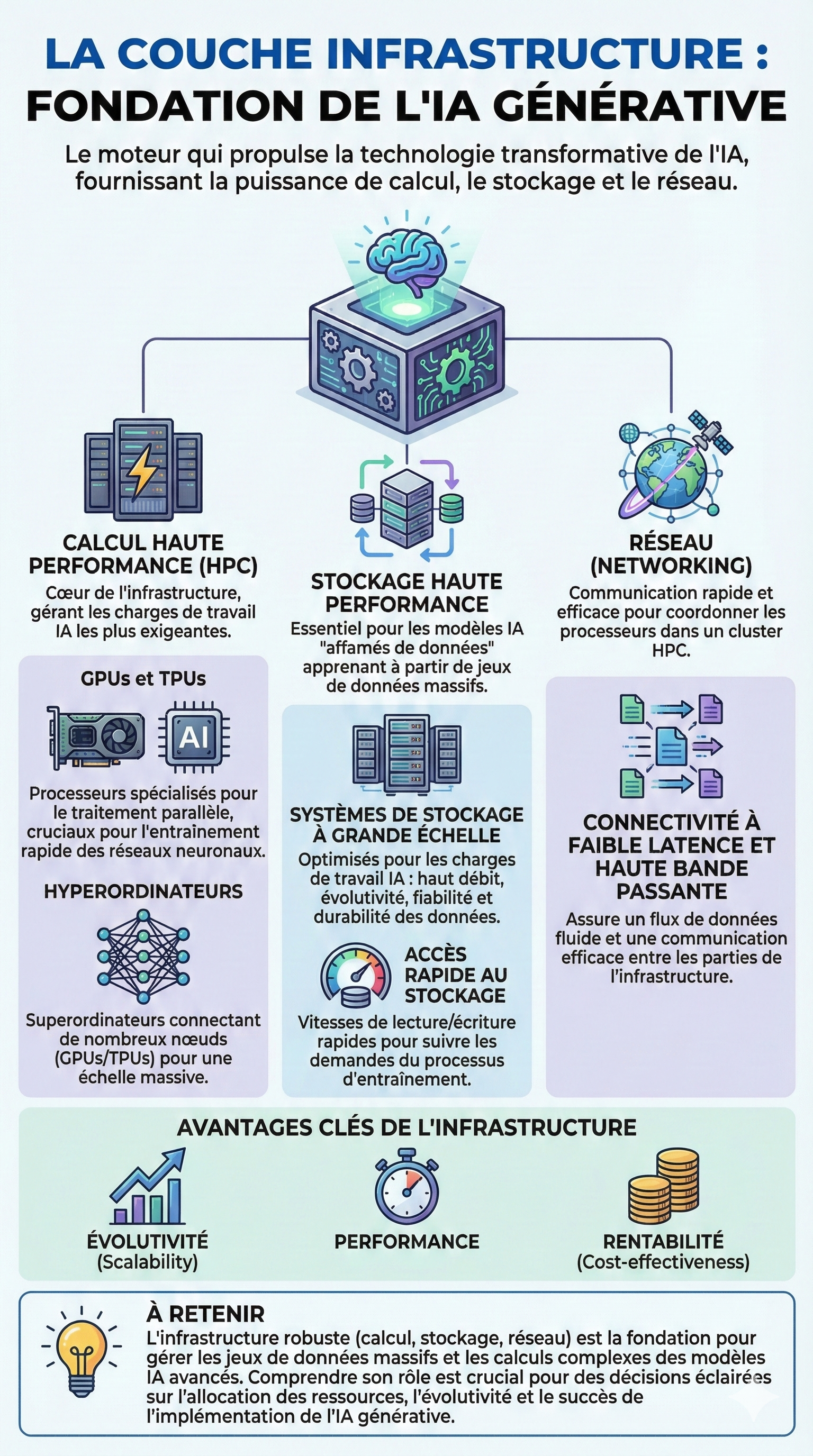

Tout en bas, l'Infrastructure : C'était les fondations. Les puces électroniques, les serveurs, la puissance brute. Fallait-il une infrastructure massive pour le marketing ? Oui. Pour le technicien dans le tunnel ? Non, il lui fallait de la légèreté.

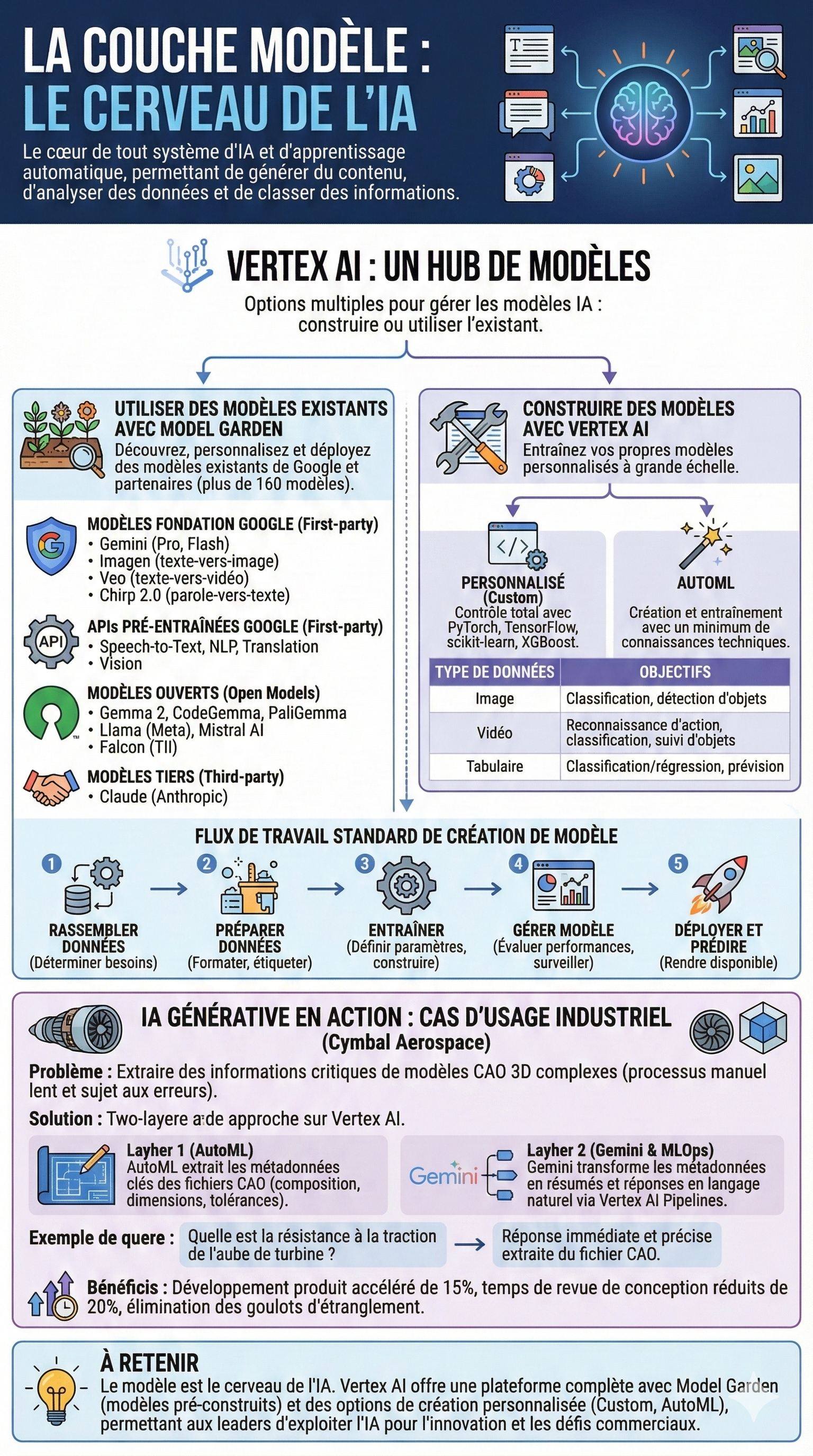

Au milieu, les Modèles : Les cerveaux. Claire comprit qu'il en existait de toutes les tailles. Pourquoi payer pour un "génie universel" (comme Gemini Ultra) pour simplement trier des emails ? Un "petit cerveau" spécialisé suffirait.

Tout en haut, les Agents : Ce n'étaient plus de simples robots conversationnels, mais de véritables employés numériques capables d'enchaîner des actions complexes.

Claire prit son marqueur. Elle n'était plus seulement celle qui utilisait l'IA. Elle était devenue l'Architecte. Elle allait devoir décider quel cerveau (Modèle) mettre dans quel corps (Infrastructure), pour quel usage (Agent), et à quel coût.

L'heure du bricolage génial était terminée. L'ère de la stratégie industrielle commençait.

L'Anatomie du Système : Mettre fin à la confusion

La réunion de mardi matin avait mal commencé. Autour de la table, le jargon volait bas et les quiproquos s'accumulaient. Le projet de "Super Assistant" de l'entreprise était au point mort, bloqué par une incompréhension totale entre les départements.

— "On doit acheter un nouvel Agent pour le serveur !" lançait Julien, le responsable marketing, visiblement agacé.

— "Mais non, Julien ! C'est l'Application qui doit être mise à jour sur la Plateforme," rétorquait le chef de projet IT en levant les yeux au ciel.

— "De toute façon, c'est le Modèle qui coûte trop cher en Infrastructure," grommelait le Directeur Financier, le nez dans ses tableaux Excel. "Google nous facture quoi, là ? Des puces ou du code ?"

Claire écoutait, fascinée par ce dialogue de sourds. Tout le monde utilisait les mots "IA", "Modèle", "Agent" et "Appli" de manière interchangeable, comme si c'était une seule et même bouillie technologique. C'était la recette parfaite pour un échec coûteux.

Elle se leva calmement, attrapa le feutre noir et se dirigea vers le tableau blanc.

— "On arrête tout," dit-elle d'une voix posée qui fit taire l'assemblée. "On ne peut pas construire un gratte-ciel si on appelle 'brique' ce qui est en fait du 'ciment'. L'IA Générative n'est pas un bloc monolithique magique. C'est un système interconnecté de cinq couches géologiques. Et si nous voulons réussir, nous devons comprendre le rôle de chacune."

Elle effaça les gribouillages précédents et dessina une grande pyramide divisée en cinq étages, du bas vers le haut.

1. Les fondations invisibles : L'Infrastructure

Elle pointa la base large de la pyramide.

— "Tout commence ici. L'Infrastructure. C'est le physique. Ce sont les serveurs, les puces spécialisées dont vous entendez parler aux infos (GPU, TPU) et les câbles."

Elle se tourna vers le Directeur Financier.

— "Marc, quand tu parles de coûts de calcul lourds, c'est ici que ça se passe. C'est la fondation sur laquelle tout repose. C'est la route et le carburant. Sans cette puissance de calcul brute fournie par Google Cloud, rien ne tourne. C'est le socle matériel."

2. Le moteur intellectuel : Le Modèle

Elle remonta d'un cran sur son dessin.

— "Posé sur cette infrastructure, il y a le Modèle. C'est le cerveau. C'est Gemini, c'est Imagen. Ce sont ces algorithmes complexes entraînés sur des milliards de données qui ont appris à prédire le mot suivant, à traduire ou à dessiner."

Elle regarda le marketing.

— "Julien, le modèle, c'est le moteur de la voiture. Il génère la puissance (le contenu), mais il ne sait pas où aller tout seul. Il attend qu'on lui pose une question. Il est puissant, mais passif."

3. Le connecteur : La Plateforme

Au milieu de son schéma, Claire dessina un trait épais représentant une boîte à outils.

— "C'est ici que beaucoup font l'erreur. Entre le cerveau (Modèle) et l'action (Agent), il faut un liant. C'est la Plateforme. Pour nous, c'est Vertex AI."

Elle expliqua que la plateforme est l'ossature qui tient tout ensemble. Elle fournit les APIs, les outils pour gérer les données, déployer les modèles et sécuriser les accès.

— "C'est le châssis de la voiture. C'est l'usine qui nous permet de changer de moteur (Modèle) sans avoir à reconstruire toute la voiture. C'est grâce à la plateforme qu'on gagne en agilité et qu'on ne réinvente pas la roue à chaque projet."

4. Le nouveau venu : L'Agent

Claire encercla l'étage suivant avec insistance.

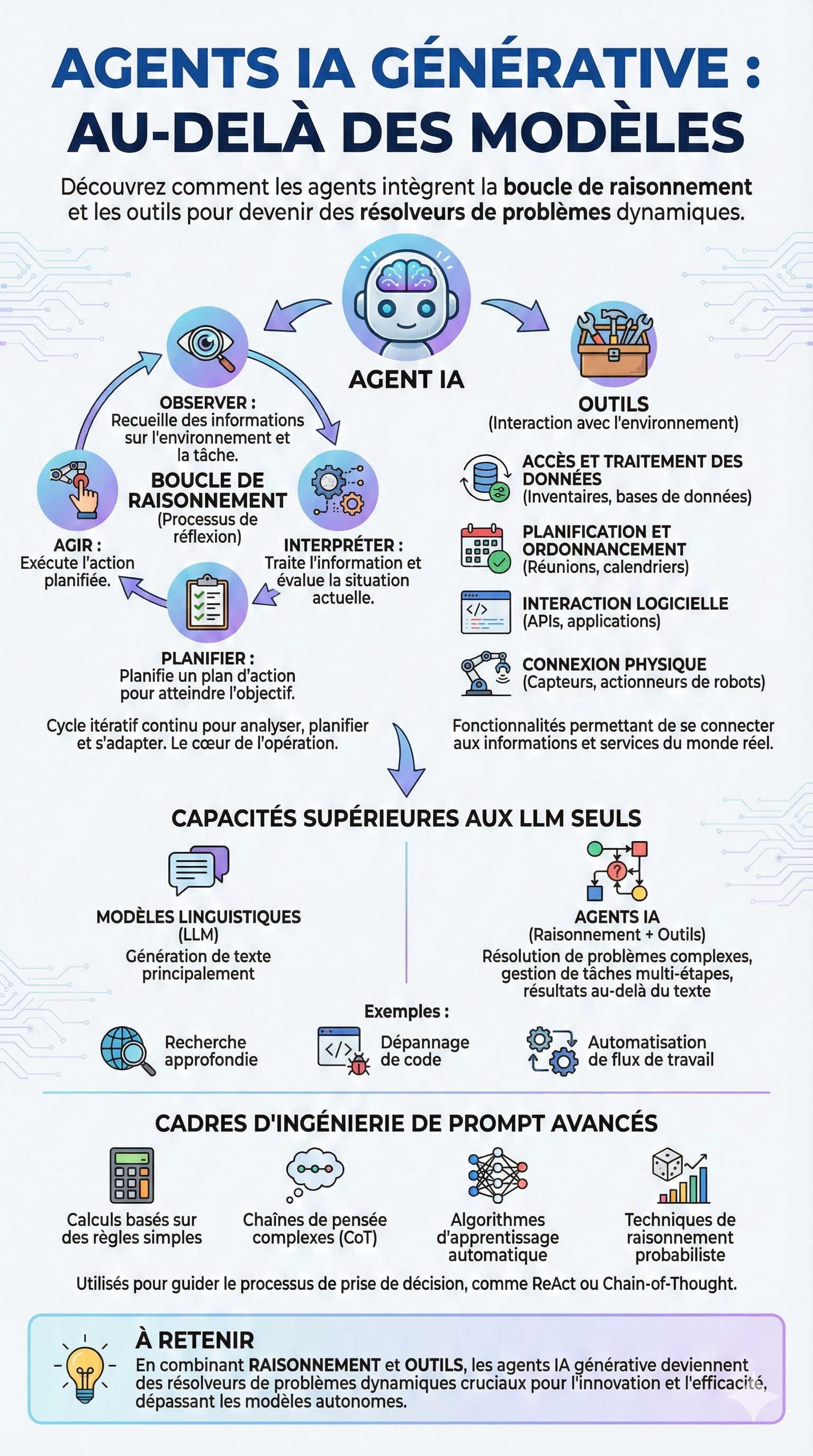

— "C'est là que se joue notre futur immédiat. L'Agent. C'est un logiciel capable d'autonomie. Il a un objectif."

Pour illustrer, elle utilisa une analogie simple :

— "Le Modèle est comme un encyclopédiste très intelligent assis dans une pièce fermée. Si vous lui demandez comment réparer une fuite, il vous écrit un manuel parfait.

L'Agent, c'est ce même encyclopédiste, mais on lui a donné des bras et une caisse à outils. Il ne se contente pas de dire comment réparer : il observe la fuite, il planifie la réparation, il commande la pièce et il agit. Il gère des tâches multi-étapes complexes."

5. La vitrine : L'Application

Enfin, elle tapota le sommet de la pyramide.

— "Et tout en haut, il y a ce que voit l'utilisateur final : l'Application. C'est l'interface. C'est l'appli Gemini sur vos téléphones, c'est Workspace, ou c'est notre futur outil interne."

Elle conclut sa démonstration :

— "L'application est le volant et le tableau de bord. Elle permet à l'humain de piloter l'Agent, qui utilise la Plateforme pour activer le Modèle, qui tourne sur l'Infrastructure."

La métaphore automobile : L'alignement des équipes

Pour s'assurer que le message était définitivement ancré, Claire utilisa l'analogie de la voiture, inspirée de sa formation, pour récapituler le rôle de chacun :

— "Imaginez que nous construisons une voiture de course pour l'entreprise :"

L'Infrastructure (GPU/TPU) : C'est la route et le carburant haute performance.

Le Modèle (Gemini) : C'est le moteur V8 sous le capot.

La Plateforme (Vertex AI) : C'est le châssis et l'électronique qui connectent tout.

L'Agent : C'est le pilote automatique qui décide de doubler, de freiner ou de changer d'itinéraire.

L'Application : C'est l'habitacle confortable avec le GPS où s'assoit le passager (l'employé).

Le silence se fit dans la salle. Puis, les têtes commencèrent à hocher. La tension retomba instantanément.

— "D'accord," dit le chef de projet IT, soulagé. "Donc quand le marketing veut 'plus d'intelligence créative', on doit changer le Modèle. Mais quand la Finance veut réduire la facture, on doit optimiser l'usage de l'Infrastructure. Et si on veut automatiser les commandes fournisseurs, on doit construire un Agent."

— "Exactement," sourit Claire. "En découpant le problème par couche, on sait exactement quel levier actionner."

Claire avait réussi une étape cruciale. Elle avait transformé une purée technologique incompréhensible en une carte mentale structurée. Son équipe ne parlait plus de "magie IA", mais d'architecture modulaire.

Cependant, alors qu'ils sortaient de la réunion, Julien du marketing rattrapa Claire.

— "C'est super clair, Claire. Mais j'ai encore un doute sur la différence entre l'Application et l'Agent. Dans mon projet, j'ai l'impression que c'est la même chose. Mon application est intelligente, non ?"

Claire comprit qu'il fallait creuser ce point précis. C'était la transition parfaite vers le prochain défi : comprendre la relation symbiotique, mais distincte, entre la scène (l'Application) et l'acteur (l'Agent).

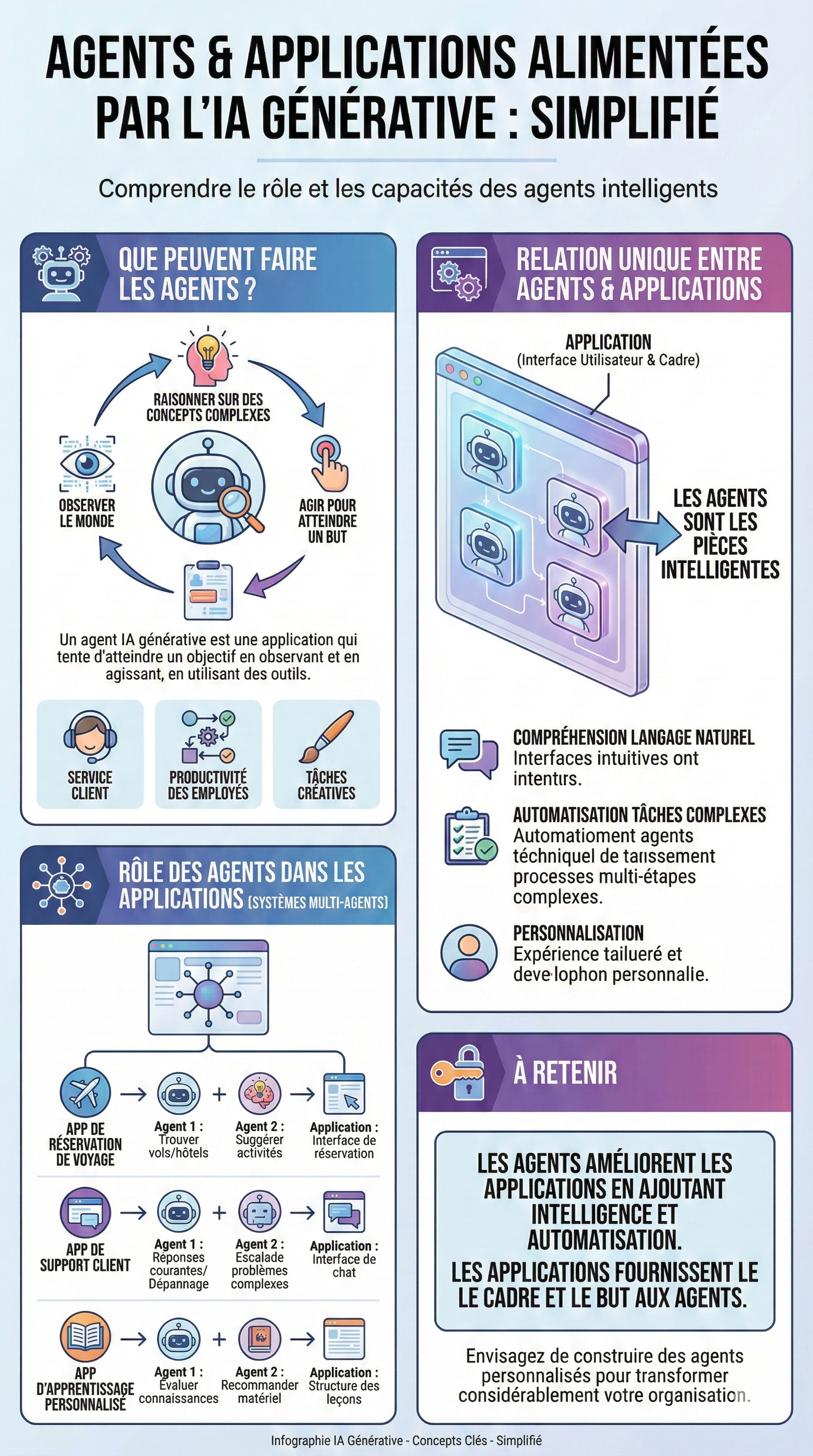

Les coulisses de l'application : L'ère des Agents

La pyramide de Claire était toujours au tableau, mais une nouvelle question brûlait les lèvres de l'équipe produit. Ils travaillaient sur la refonte de l'application mobile interne, destinée à aider les commerciaux à préparer leurs déplacements et leurs rendez-vous clients.

Lucas, le Lead Designer, semblait frustré. Il fit tourner son prototype sur l'écran géant.

— "Regardez ça. On a dessiné une super interface. On a mis un champ de chat magnifique. Mais pour l'instant, c'est juste une coquille vide qui fait de la conversation de salon. Si je dis 'Je vais voir le client TechCorp', l'IA me répond 'C'est super, TechCorp est une belle entreprise'. C'est poli, mais ça ne sert à rien ! Comment on rend ce truc vraiment utile ?"

Claire sourit. C'était le moment idéal pour faire la distinction la plus importante de leur transformation : la différence entre l'Application et l'Agent.

L'Application vs L'Agent : La scène et les acteurs

Claire prit un feutre rouge. Elle dessina un grand rectangle (l'Application) et, à l'intérieur, plusieurs petits bonhommes (les Agents).

— "Lucas, ton problème, c'est que tu as construit un théâtre magnifique, mais tu as oublié d'embaucher la troupe. Ton application, c'est le théâtre. C'est la scène, le décor, les sièges pour le public. C'est la couche visible (User-Facing Layer) qui permet à l'utilisateur d'entrer."

Elle pointa les petits bonhommes.

— "Mais un théâtre vide, c'est ennuyeux. Ce qui donne vie à la pièce, ce sont les Agents. Ce sont les morceaux d'intelligence qui font réellement le travail, qui ont un but et qui utilisent des outils."

Elle se tourna vers l'équipe.

— "Une application fournit la structure et le contexte. Un agent poursuit un objectif."

Observer, Raisonner, Agir

Pour rendre le concept concret, elle reprit l'exemple de l'application pour les commerciaux.

— "Reprenons ton exemple, Lucas. Aujourd'hui, ton chatbot est passif. Imaginez maintenant qu'on intègre un véritable Agent Gen AI dans l'application. Contrairement à un simple modèle de langage, l'Agent est programmé pour Observer le monde et Agir dessus."

Elle écrivit au tableau le processus :

Observer : L'agent voit dans mon agenda que j'ai une réunion à Lyon demain à 14h avec le client 'TechCorp'.

Raisonner : Il se dit 'Claire n'a pas encore de billet de train, et TechCorp est un client difficile qui nécessite une préparation solide'.

Agir : Il ne se contente pas de parler. Il utilise ses outils pour résoudre le problème.

La puissance du Système Multi-Agents

Lucas était intrigué, mais sceptique.

— "Ça fait beaucoup pour une seule IA, non ? Elle risque de s'emmêler les pinceaux entre la réservation de train et l'analyse financière."

— "C'est là que ça devient fascinant," répondit Claire. "On ne va pas créer un seul agent à tout faire. On va créer une équipe d'agents spécialisés (Multi-Agent System). Ton application sera leur bureau commun."

Elle dessina trois profils distincts dans le rectangle de l'application :

L'Agent "Travel" : "Sa seule mission est la logistique. Il connaît mes préférences (fenêtre, 2nde classe). Il a accès à l'API de réservation. Il trouve le meilleur train et l'hôtel, et me propose de valider."

L'Agent "Sales Coach" : "Lui, il est connecté au CRM. Il analyse l'historique du client TechCorp, repère les dernières plaintes et me suggère des arguments de vente pour mon rendez-vous."

L'Agent "Assistant Perso" : "Il vérifie la météo à Lyon et me suggère de prendre un parapluie."

— "L'Application mobile," conclut Claire, "c'est juste le chef d'orchestre qui présente les résultats de ces trois agents de manière fluide à l'utilisateur. Elle offre l'interface intuitive, mais ce sont les agents qui automatisent les tâches complexes en arrière-plan."

La démocratisation par le langage naturel

Un développeur junior leva la main, inquiet.

— "Claire, coder trois intelligences artificielles distinctes qui se coordonnent... ça va nous prendre deux ans de dev complexe."

Claire le rassura immédiatement. C'était l'autre bonne nouvelle de sa formation.

— "C'est fini, l'époque où il fallait écrire des milliers de lignes de code complexe pour chaque action. Avec les outils d'AI Applications de Google Cloud, on crée ces agents avec le langage naturel."

Elle expliqua :

— "Pour créer l'Agent 'Travel', tu ne vas pas coder des boucles if/then. Tu vas lui donner une instruction en français (ou en anglais) : 'Tu es un expert en voyage. Ton but est de trouver le trajet le plus rapide. Tu as accès à l'outil de réservation. Si le prix dépasse 200€, demande une validation.'"

L'équipe réalisa soudain que la barrière technique s'était effondrée. La vraie compétence n'était plus de savoir coder la logique, mais de savoir définir la mission de l'agent.

La réunion se termina dans une effervescence créative. L'équipe ne voyait plus leur application comme un simple outil passif, mais comme une ruche abritant des agents spécialisés.

La réunion se termina dans une effervescence créative. L'équipe ne voyait plus leur application comme un simple outil passif, mais comme une ruche abritant des agents spécialisés.

Claire avait réussi à faire passer un message clé :

L'Application est la carrosserie (l'expérience utilisateur, la personnalisation).

Les Agents sont le moteur intelligent (l'automatisation des tâches complexes).

En sortant, Lucas l'interpella : "En fait, Claire, on n'est plus en train de construire un logiciel pour nos commerciaux. On est en train de leur construire une équipe d'assistants virtuels."

Claire sourit. "Exactement. Et maintenant, il va falloir décider comment ces agents prennent leurs décisions."

C'était la transition parfaite vers le prochain défi : comprendre comment ces agents "pensent" vraiment. C'était l'heure de découvrir deux types d'agents bien distincts : ceux avec qui on discute, et ceux qui travaillent en silence.

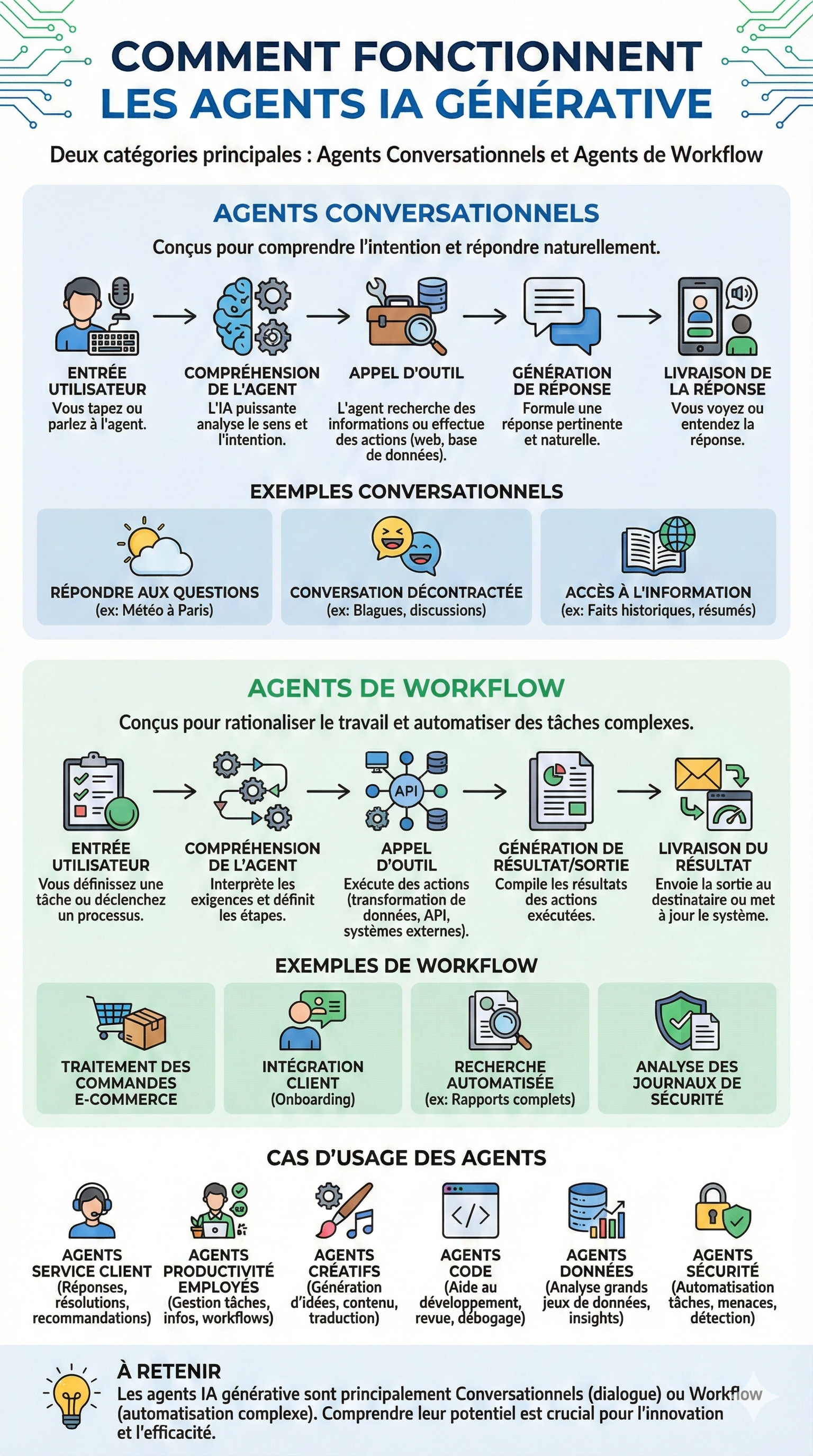

Deux salles, deux ambiances : Conversation vs Workflow

Le lendemain, Claire se retrouva face à un dilemme opérationnel. Son équipe IT était en train de développer deux projets en parallèle, et les retours des utilisateurs bêta-testeurs étaient catastrophiques.

Projet A (Service Client) : Les clients se plaignaient que le chatbot était trop rigide, incapable de comprendre des nuances.

Projet B (Note de Frais) : Les employés se plaignaient que l'assistant virtuel était trop bavard. "Je veux juste uploader mon ticket de train, je ne veux pas qu'il me demande comment s'est passé mon voyage !" s'était énervé un commercial.

Claire comprit immédiatement le problème. Ses équipes utilisaient les mauvais outils pour les mauvaises tâches. Ils confondaient les deux grandes familles d'agents : les Agents Conversationnels et les Agents de Workflow.

Elle convoqua une réunion d'urgence pour clarifier la situation.

1. Le Concierge : L'Agent Conversationnel

Claire projeta une image d'un hall d'hôtel de luxe.

— "Pour le Service Client, nous avons besoin d'un Concierge. C'est un Agent Conversationnel."

Elle expliqua le fonctionnement à l'équipe du Projet A :

— "Votre but n'est pas d'exécuter une tâche aveugle. Votre but est de comprendre l'intention humaine."

Elle détailla le cycle de vie de cet agent :

L'Input : Le client tape "Ma box clignote rouge".

La Compréhension : L'agent ne cherche pas juste le mot "rouge". Il comprend l'intention : "Panne technique, stress du client, besoin de diagnostic".

L'Appel d'outil : Il va chercher la documentation technique ou l'état du réseau.

La Réponse : Il formule une réponse empathique et naturelle, pas un code d'erreur robotique.

— "Un agent conversationnel est là pour dialoguer, résumer, expliquer, ou même divertir," insista Claire. "Si le client veut savoir le temps qu'il fait à Paris ou avoir un résumé de la Révolution Française, cet agent doit pouvoir répondre avec fluidité."

2. Le Chef d'Usine : L'Agent de Workflow

Ensuite, elle changea de slide pour montrer une ligne d'assemblage automatisée.

— "Pour les notes de frais, c'est l'inverse. Nous n'avons pas besoin d'un ami. Nous avons besoin d'un Chef d'Usine. C'est un Agent de Workflow."

Elle se tourna vers l'équipe du Projet B :

— "Les employés ne veulent pas discuter. Ils veulent que le travail soit fait."

Elle décrivit le processus idéal pour cet agent :

Le Déclencheur : L'employé dépose un fichier PDF (son ticket de train).

L'Analyse silencieuse : L'agent ne parle pas. Il lit le fichier, extrait la date, le montant et la TVA.

L'Exécution (Outils) : Il se connecte à l'ERP (logiciel comptable), vérifie si le montant correspond à la politique voyage, et valide l'écriture comptable.

Le Résultat : Il envoie une simple notification : "Remboursement validé". Fin de l'histoire.

— "L'Agent de Workflow est là pour l'efficacité," résuma Claire. "Il transforme, il transfère, il automatise. Il est invisible mais indispensable."

La bonne étiquette pour le bon usage

Forte de cette distinction, Claire aida ses équipes à re-catégoriser tous les projets en cours. Elle dessina une matrice au tableau pour répartir les rôles :

Le Service Client ? -> Agent Conversationnel. Il doit gérer l'ambiguïté du langage humain, calmer un client énervé ou recommander un produit.

La Sécurité Informatique ? -> Agent de Workflow. Si une menace est détectée, on ne veut pas discuter. L'agent doit isoler le serveur infecté, scanner les logs et générer un rapport d'incident immédiatement.

Les Développeurs ? -> Agent de Code. Un hybride. Il doit comprendre la demande ("Optimise cette fonction") de manière conversationnelle, mais agir sur le code comme un workflow rigoureux.

Le Marketing ? -> Agent Créatif. Il doit brainstormer des idées de slogans (Conversationnel) mais aussi générer et formater les visuels aux bonnes dimensions pour Instagram (Workflow).

L'Équipe Data ? -> Agent de Données. Il doit être capable de digérer un fichier Excel de 10 000 lignes pour en extraire une tendance que l'humain n'avait pas vue.

En fin de journée, la tension était retombée. Les développeurs savaient désormais ce qu'ils devaient construire.

En fin de journée, la tension était retombée. Les développeurs savaient désormais ce qu'ils devaient construire.

Claire réalisa qu'elle était en train de composer une symphonie. Elle avait ses solistes (les agents conversationnels) pour interagir avec le public, et sa section rythmique (les agents de workflow) pour tenir la cadence en arrière-plan.

— "C'est clair pour tout le monde ?" demanda-t-elle.

— "Oui," répondit le chef de projet IT. "Pour les tâches humaines, on discute. Pour les tâches robotiques, on automatise."

Claire sourit. Elle avait franchi une étape majeure : comprendre quoi demander à l'IA. Mais une question subsistait, plus profonde : comment ces agents, qu'ils soient bavards ou silencieux, font-ils pour être intelligents ? Comment font-ils pour ne pas juste répéter ce qu'ils ont appris, mais pour réfléchir face à un problème nouveau ?

C'était l'heure de découvrir le secret le mieux gardé des agents : la boucle de raisonnement.

Le syndrome du "Cerveau dans le bocal"

Le mercredi après-midi, Claire fut convoquée d'urgence dans le bureau de Pierre, le Directeur de la Supply Chain. L'ambiance était glaciale. Sur l'écran géant, une conversation avec le prototype d'IA que l'équipe IT venait de livrer était affichée.

— "Regarde ça, Claire," gronda Pierre en pointant l'écran. "On a une rupture critique de stock sur les micro-processeurs pour l'usine de Bordeaux. J'ai demandé à ton IA de 'gérer le problème'. Regarde ce qu'elle a fait."

Claire lut la réponse de l'IA :

"Chère équipe de Bordeaux, je suis navrée d'apprendre cette pénurie. Les micro-processeurs sont essentiels. Voici une liste de cinq conseils pour gérer le stress lié aux retards de production."

Pierre était rouge de colère.

— "Des conseils de gestion du stress !? J'ai une ligne de production à 50 000€ l'heure qui va s'arrêter, et ton IA me fait de la psychologie ! Je croyais que l'IA Générative était une révolution ?"

Claire comprit immédiatement. C'était l'erreur classique du débutant. Pierre essayait de faire faire de la gestion de projet à un poète.

— "Pierre, calme-toi. L'outil n'est pas cassé. C'est juste qu'on lui a demandé l'impossible. On a utilisé un Modèle, alors qu'il te faut un Agent."

Le Modèle vs L'Agent : L'Encyclopédie et l'Employé

Claire s'empara d'un feutre effaçable et dessina un bocal avec un cerveau dedans sur le tableau blanc de Pierre.

— "Ce que tu as utilisé, c'est ça. Un Modèle (LLM). C'est comme un génie enfermé dans un bocal. Il a lu tout internet, il sait écrire des lettres parfaites et il est très empathique. Mais il n'a ni bras, ni jambes, ni yeux sur notre monde réel. Il ne peut que générer du texte."

À côté, elle dessina un personnage avec un casque de chantier, tenant une caisse à outils.

— "Ce qu'il te faut, c'est un Agent. Un agent utilise le cerveau du modèle, mais on lui ajoute deux choses qui changent tout : une Boucle de Raisonnement (pour réfléchir) et des Outils (pour agir)."

La Boucle de Raisonnement : Apprendre à la machine à penser

Pierre croisa les bras, sceptique.

— "C'est quoi cette boucle ? Ça ressemble à du jargon."

— "C'est le processus qui transforme l'IA en résolveur de problèmes," répondit Claire. "Au lieu de répondre du tac au tac, l'Agent s'arrête et réfléchit."

Elle écrivit au tableau le cycle O.I.P.A. :

Observer (Observe) : "L'agent ne se contente pas de lire ton message. Il va 'regarder' l'état réel de ton stock dans notre logiciel SAP."

Interpréter (Interpret) : "Il analyse : 'Stock à 0. Commande en cours : Aucune. Impact : Arrêt critique dans 4h'."

Planifier (Plan) : "C'est là que la magie opère. Il construit un plan d'action : '1. Identifier les fournisseurs alternatifs. 2. Vérifier leurs délais. 3. Passer commande au plus rapide.'"

Agir (Act) : "Il exécute le plan."

— "C'est une boucle itérative," insista Claire. "Si l'agent voit que le Fournisseur A est en rupture, il recommence la boucle, réajuste son plan et contacte le Fournisseur B. Il ne s'arrête que quand le problème est résolu."

Les Outils : Donner des mains au cerveau

Pierre semblait intéressé, mais il pointa une faille.

— "D'accord pour la théorie. Mais comment ton Agent peut-il 'voir' SAP ou 'passer' une commande ? L'IA ne peut pas cliquer sur des boutons."

— "C'est la deuxième pièce du puzzle : les Outils," expliqua Claire.

Elle dessina des câbles reliant le petit personnage à différents blocs : l'Agenda, l'Inventaire, les Emails.

— "Un Agent, c'est comme un artisan. Il est inutile sans sa caisse à outils. Nous devons lui donner des connecteurs (des APIs) :"

Outil 1 : Accès en lecture à la base de données Stock.

Outil 2 : Accès au catalogue Fournisseurs.

Outil 3 : Capacité d'envoyer un email de commande (avec validation humaine si > 1000€).

— "Avec ces outils," conclut Claire, "l'Agent ne t'aurait pas écrit un poème sur le stress. Il aurait :

Vu la rupture (Outil 1).

Trouvé un fournisseur express en Allemagne (Outil 2).

Préparé le bon de commande pour ta signature (Outil 3)."

Pierre se rassit, l'air pensif. La colère avait disparu, remplacée par une lueur de calcul stratégique.

— "Donc, si je comprends bien... Le Modèle, c'est l'intelligence brute. L'Agent, c'est la mise en application de cette intelligence dans nos processus métiers grâce à cette boucle de raisonnement ?"

— "Exactement," sourit Claire. "Le Modèle sait. L'Agent fait."

Claire sentit qu'elle avait gagné son adhésion. Elle en profita pour aller plus loin.

Claire sentit qu'elle avait gagné son adhésion. Elle en profita pour aller plus loin.

— "Et ça ne s'arrête pas à la logistique, Pierre. On peut utiliser des techniques avancées comme le Chain-of-Thought (Chaîne de pensée). On demande à l'agent de nous expliquer sa logique étape par étape avant d'agir, pour vérifier qu'il ne fait pas d'erreur de jugement. C'est comme demander à un stagiaire : 'Dis-moi comment tu comptes t'y prendre avant de toucher à la machine'."

Pierre se leva et effaça le message du "poème sur le stress" de l'écran.

— "Ok Claire. Oublie le prototype actuel. Je veux un Agent de Workflow connecté à SAP, pas un philosophe. On commence quand ?"

Claire avait réussi à transformer une crise de confiance en un projet structuré. Elle avait prouvé que l'IA générative n'était pas magique, mais mécanique : une question d'assemblage entre un cerveau, une méthode de réflexion (la boucle) et des mains (les outils).

Mais alors qu'elle quittait le bureau de Pierre, une nouvelle question surgit. Pour construire ces Agents complexes connectés à tout le système d'information de l'entreprise, il ne suffisait pas de bricoler. Il fallait un endroit pour les construire, les entraîner et les gérer. Il fallait une usine.

C'était le moment pour Claire de s'intéresser à la couche centrale du paysage qu'elle avait à peine effleurée : la Plateforme.

Le Frankenstein numérique

Le lundi matin, l'open-space de l'équipe Data ressemblait à une scène de crime. Thomas, le Lead Développeur, avait la tête entre les mains. Marc, le Data Scientist, s'agitait frénétiquement autour d'un serveur qui soufflait comme un réacteur d'avion sous un bureau.

— "Qu'est-ce qui se passe ?" demanda Claire en posant son sac.

— "C'est la catastrophe," lâcha Thomas sans lever la tête. "L'IA de prédiction des ventes pour le Marketing a planté ce week-end. On ne sait pas pourquoi. Marc dit que c'est parce que j'ai mis à jour la librairie Python, et moi je dis que c'est son modèle qui a dérivé. En plus, on ne retrouve plus la version qui marchait la semaine dernière, elle était sur le disque dur externe de Sophie qui est en vacances."

Claire regarda autour d'elle. C'était le chaos. Des post-it avec des mots de passe collaient aux écrans, des câbles traînaient, et chacun utilisait ses propres outils dans son coin. Ils avaient réussi à construire des prototypes géniaux (les Agents), mais ils essayaient de les faire tourner avec du bricolage.

— "On arrête tout," ordonna Claire. "On ne peut pas gérer une stratégie d'entreprise avec du scotch et de la ficelle. Thomas, éteins ce serveur sous le bureau avant qu'il ne mette le feu."

Elle comprit le problème : ils avaient les ingrédients (Data) et les cuisiniers (Développeurs), mais ils cuisinaient dans une arrière-boutique clandestine au lieu d'une cuisine professionnelle. Il leur manquait la Plateforme.

Le Garage vs L'Usine : Comprendre le rôle de la Plateforme

Claire réunit l'équipe dans la salle de conférence et projeta le logo de Vertex AI.

— "Écoutez-moi. Jusqu'à présent, vous avez fait du travail d'artisan dans votre garage. C'est créatif, mais ce n'est pas scalable. Si on veut passer à l'échelle industrielle, il nous faut une usine. Cette usine, c'est la Plateforme."

Elle dessina un grand cadre englobant tout le reste.

— "La Plateforme (Vertex AI), c'est le liant (The Glue). C'est ce qui transforme des initiatives isolées en un système cohérent."

Elle lista les avantages pour calmer les inquiétudes de chacun :

Pour Thomas (Dév) : "C'est Ouvert et Flexible. Tu aimes PyTorch ? Tu aimes TensorFlow ? Vertex AI les accepte. On ne t'enferme pas, on te donne juste un cadre pro."

Pour Marc (Data) : "Fini le serveur qui chauffe sous le bureau. On utilise l'Infrastructure Puissante de Google. Si tu as besoin de 100 GPU pour une heure, tu les as. Puis tu les éteins."

Pour la Sécurité : "Plus de modèles qui traînent sur des disques durs. Tout est centralisé et sécurisé."

MLOps : L'industrialisation de l'intelligence

Marc leva la main, encore sceptique.

— "C'est bien beau l'infrastructure, Claire, mais mon problème c'est la gestion des versions de mes modèles. C'est le bazar."

— "C'est là que Vertex AI change la donne," répondit Claire. "Ça ne fournit pas juste des machines, ça fournit une méthodologie : le MLOps (Machine Learning Operations)."

Elle utilisa une nouvelle métaphore pour illustrer ce concept barbare.

— "Imaginez une chaîne d'embouteillage d'eau minérale."

Elle dessina la chaîne au tableau, étape par étape :

Le Feature Store (L'Entrepôt d'Ingrédients) :

"Aujourd'hui, quand le Marketing et la Finance calculent le 'Chiffre d'Affaires', ils utilisent deux formules différentes. C'est fini. On stocke la définition officielle ici. Tout le monde puise dans la même source. Cohérence garantie."

Le Model Registry (La Bibliothèque) :

"Thomas, ton problème de version perdue ? Terminé. Le Model Registry est comme une bibliothèque sécurisée. Chaque version de l'IA est étiquetée, datée et rangée. Si la v2 plante, on revient à la v1 en un clic."

L'Orchestration de Workflow (Le Tapis Roulant) :

"Plus d'interventions manuelles risquées. On utilise les Pipelines. De la donnée brute jusqu'au déploiement, tout est automatisé sur un tapis roulant virtuel. Ça réduit les erreurs humaines de 90%."

Model Monitoring (Le Contrôle Qualité) :

"Et pour ton crash du week-end, Marc... Vertex AI inclut des capteurs. Si l'IA commence à dire n'importe quoi (ce qu'on appelle la dérive ou le drift), le système nous envoie une alerte avant que le Marketing ne s'en aperçoive."

Un silence apaisé s'installa dans la salle. L'équipe IT ne voyait plus la plateforme comme une contrainte administrative, mais comme un filet de sécurité.

Un silence apaisé s'installa dans la salle. L'équipe IT ne voyait plus la plateforme comme une contrainte administrative, mais comme un filet de sécurité.

— "Vertex AI," conclut Claire, "c'est ce qui nous permet de passer du statut de 'Start-up interne bordélique' à celui de 'Département IA d'Entreprise'. On garde la créativité, mais on supprime le chaos."

Thomas referma son ordinateur portable.

— "Ok, on migre tout sur Vertex. Je ne veux plus jamais passer un week-end à débugger une version fantôme."

Claire avait réussi à structurer le "Comment". Elle avait l'usine (La Plateforme Vertex AI), elle avait les ouvriers (Les Agents), et elle avait les fondations (L'Infrastructure).

Mais une usine vide ne produit rien. Il manquait encore l'élément central, la pièce maîtresse qui allait habiter cette plateforme et donner vie aux agents. Il fallait choisir le "cerveau" de l'opération.

Claire se tourna vers Marc.

— "L'usine est prête. Maintenant, dis-moi... Quel Modèle on met dedans ? On prend le plus gros ? Le plus rapide ? Ou le moins cher ?"

C'était l'heure d'entrer dans le Model Garden.

Le Supermarché des Cerveaux (The model layer)

Le jeudi matin, Claire entra dans la salle de "War Room" et trouva Thomas, son Lead Développeur, le teint gris, les yeux cernés, entouré de canettes de boissons énergisantes vides.

— "Thomas, tu as dormi ici ?" demanda-t-elle doucement.

— "Pas le temps," grogna Thomas. "Le lancement de notre site e-commerce au Japon est dans trois semaines. Je suis en train de coder un réseau de neurones pour la traduction automatique des fiches produits. J'en suis à l'entraînement de la couche 4, mais ça ne marche pas, le modèle confond 'chaussette' et 'chaussure'. Je vais devoir tout recommencer."

À l'autre bout de la table, Sophie, la directrice R&D, soupirait.

— "Et moi, j'attends toujours que Thomas m'aide. Mes ingénieurs perdent 20% de leur temps à chercher des infos techniques dans nos 50 000 schémas de pièces détachées (CAD). On a besoin d'une IA capable de 'lire' ces schémas, mais Thomas me dit qu'il lui faut six mois pour bâtir le modèle."

Claire sentit la crise monter. Son équipe essayait de construire des moteurs de Ferrari avec des limes à ongles. Ils avaient la Plateforme (l'usine), mais ils s'obstinaient à fabriquer chaque pièce à la main.

— "Stop," ordonna Claire. "Thomas, arrête de coder. Sophie, arrête d'attendre. Vous faites fausse route. Vous essayez de fabriquer des cerveaux alors qu'on peut les louer."

Elle alluma l'écran géant et connecta son ordinateur à Vertex AI.

Le Model Garden : Faire ses courses au lieu de cultiver son potager

Claire afficha une page remplie de cartes colorées : le Model Garden.

— "Imaginez que vous devez préparer un dîner de gala," commença Claire. "Thomas, ce que tu fais, c'est essayer de faire pousser ton propre blé pour faire ta farine, pour ensuite cuire ton pain. C'est noble, mais on a faim maintenant."

Elle pointa l'écran.

— "Voici le Grand Marché (Model Garden). Ici, Google et ses partenaires ont déjà cultivé les meilleurs ingrédients du monde. On n'a pas besoin de créer un modèle, on a juste besoin de choisir le bon."

Elle fit défiler les catégories :

Les Spécialistes Maison (First-party Models) :

— "Thomas, pour tes traductions japonaises, regarde ça : les APIs pré-entrainées. Google Translate et les modèles de langage (NLP) sont déjà parfaits. Pourquoi tu veux les refaire ? Et pour les descriptions produits, on prend Gemini Pro. C'est un génie polyvalent."

— "Et pour les visuels de la campagne ?" demanda le marketing présent au fond de la salle.

— "On prend Imagen. C'est l'artiste de la bande. Texte vers Image. Hop, c'est réglé."

Les Partenaires et l'Open Source :

— "Si on a des besoins spécifiques ou si on veut garder le contrôle total du code, on peut piocher dans les Open Models. Regardez : Llama de Meta, Mistral AI... Ils sont tous là, prêts à être déployés sur notre infrastructure Vertex en un clic."

Thomas semblait déconfit, mais soulagé.

— "Donc... je peux juste connecter l'API de Gemini et aller dormir ?"

— "Exactement," sourit Claire.

Le Costume Sur-Mesure : La puissance d'AutoML

Sophie, la R&D, n'était pas convaincue.

— "C'est bien joli ton supermarché, Claire. Mais mes schémas techniques sont ultra-spécifiques. Ton 'Gemini' ne sait pas faire la différence entre une valve pressurisée de type A et de type B. Aucun modèle générique ne le sait."

Claire se tourna vers elle.

— "Tu as raison. Pour toi, le prêt-à-porter ne suffit pas. Il te faut du sur-mesure. Mais on ne va pas tisser le tissu nous-mêmes. On va utiliser AutoML."

Elle expliqua le concept :

— "AutoML, c'est comme engager un apprenti très doué. Il ne connaît rien à tes valves pour l'instant. Mais si tu lui montres des exemples, il apprend tout seul, sans que Thomas n'écrive une ligne de code complexe."

Claire dessina au tableau le workflow standard pour Sophie, inspiré du cas réel de Cymbal Aerospace qu'elle avait étudié :

Gather (Rassembler) : "Sophie, donne-nous 1000 images de tes schémas."

Prepare (Préparer) : "Tes ingénieurs étiquettent les images : 'Ça c'est une valve', 'Ça c'est un piston'. C'est la seule chose humaine à faire."

Train (Entraîner) : "On clique sur 'Go'. Vertex AI utilise sa puissance pour trouver les motifs visuels (patterns) qui définissent une valve."

Evaluate & Deploy : "On vérifie si l'apprenti a bien appris, et on le met en production."

— "Et pour aller plus loin," ajouta Claire avec enthousiasme, "on va combiner ça avec Gemini. Une fois que AutoML a identifié la pièce sur le plan, on envoie l'info à Gemini pour qu'il rédige le résumé technique en langage naturel pour tes ingénieurs."

Sophie écarquilla les yeux.

— "Tu veux dire qu'on peut mixer un modèle visuel spécialiste et un modèle textuel généraliste ?"

— "C'est exactement ça la puissance de la plateforme. On assemble les briques."

Pour clore la réunion, Claire distribua les tâches en mode "Casting". Elle ne parlait plus de code, mais de talents à recruter :

Pour clore la réunion, Claire distribua les tâches en mode "Casting". Elle ne parlait plus de code, mais de talents à recruter :

Pour le Site E-commerce (Japon) : "On recrute Gemini via l'API. Rapide, efficace, multilingue. Thomas, implémente ça, ça te prendra deux jours."

Pour la R&D (Schémas) : "On lance un entraînement AutoML sur nos images propriétaires. C'est du custom, c'est notre propriété intellectuelle."

Pour le Service Client (Vocal) : "On va tester Chirp 2.0, le spécialiste du Speech-to-Text, pour transcrire les appels."

L'atmosphère dans la salle avait changé. De la lourdeur du développement "from scratch", ils étaient passés à l'agilité de l'assemblage. Thomas rangeait déjà ses canettes, prêt à rentrer chez lui se reposer.

Claire avait résolu le problème des "Cerveaux". Elle avait accès aux meilleurs modèles du monde via le Model Garden, et elle avait la méthode pour entraîner les siens via AutoML.

Cependant, alors qu'elle éteignait l'écran géant, une pensée lui traversa l'esprit. Elle venait de commander une armée de modèles puissants : Gemini, Imagen, des modèles custom lourds... Tout cela allait demander une puissance de feu colossale.

Elle regarda la petite salle serveur de l'entreprise.

— "On va avoir un problème," murmura-t-elle. "Ces cerveaux sont géniaux, mais ils vont avoir besoin d'un corps capable de les supporter. Il va falloir parler hardware."

C'était l'heure de descendre au sous-sol de la pyramide : l'Infrastructure.

Le Goulot d'Étranglement : Quand le Cerveau attend le Corps

Le vendredi après-midi, à dix jours du lancement du projet "Vision Industrielle" (celui qui devait analyser les schémas techniques avec AutoML), Claire reçut un SMS laconique de Sophie, la directrice R&D : "C'est mort. On n'y arrivera pas."

Claire descendit quatre à quatre les escaliers vers le sous-sol, là où l'équipe IT gardait ses serveurs "maison". Une chaleur étouffante régnait dans la pièce. Le bruit des ventilateurs était assourdissant.

Sophie pointait un écran du doigt, dépitée. Une barre de chargement était affichée : "Entraînement du modèle : 12%... Temps estimé restant : 3 semaines."

— "Regarde ça, Claire," hurla presque Sophie pour couvrir le bruit. "On a les données, on a le modèle AutoML, tout est prêt. Mais nos serveurs n'en peuvent plus. Ils calculent jour et nuit depuis mardi, et on avance à la vitesse d'un escargot. À ce rythme, l'IA sera prête pour Noël... de l'année prochaine."

Thomas, le Lead Dev, épongeait son front.

— "C'est de l'apprentissage profond (Deep Learning), Claire. Ça demande des milliards de calculs mathématiques à la seconde. Nos cartes graphiques classiques sont en train de fondre. On ne peut pas traiter des pétaoctets de données avec du matériel de bureau."

Claire réalisa l'erreur stratégique. Ils avaient commandé un moteur de Formule 1 (le Modèle), mais ils essayaient de le monter sur un vélo (leur infrastructure locale).

— "Coupez tout," ordonna Claire. "On ne va pas attendre trois semaines. On migre l'entraînement sur l'Infrastructure de Google Cloud maintenant."

La Métaphore de la "Brigade de Cuisine"

Remontés dans le calme d'une salle de réunion, Claire devait expliquer à son équipe pourquoi louer de la puissance à distance allait résoudre ce problème physique. Elle devait vulgariser le concept de High Performance Computing (HPC).

Elle dessina une cuisine de restaurant géante au tableau.

— "Le problème, ce n'est pas la recette (le Modèle), c'est la cuisine (l'Infrastructure). Pour l'instant, Thomas est tout seul à couper des carottes avec un couteau émoussé."

Elle détailla les quatre piliers de l'infrastructure IA nécessaire :

1. La Puissance de Calcul (Compute) : Les Chefs Cuisiniers

— "Dans l'IA, le processeur est le chef qui cuisine les données. Nous avons deux types de chefs à notre disposition chez Google :"

Les GPUs (Graphics Processing Units) : "C'est le chef polyvalent. À l'origine, il dessinait des jeux vidéo (graphisme), mais il est excellent pour faire plusieurs choses en même temps (calcul parallèle). C'est le couteau suisse."

Les TPUs (Tensor Processing Units) : "Ça, c'est l'arme secrète de Google. C'est un chef étoilé spécialisé uniquement dans l'IA. Il a été conçu sur mesure pour les réseaux de neurones. Pour ton projet AutoML, Sophie, un TPU va traiter tes matrices mathématiques 50 fois plus vite que nos serveurs actuels."

2. L'Hyperordinateur : La Brigade Synchronisée

Claire dessina plusieurs bonhommes connectés entre eux.

— "Mais un seul chef, même très fort, ne suffit pas pour nos téraoctets de données. Il nous faut un Hyperordinateur. C'est une architecture qui relie des milliers de puces (Noeuds) pour qu'elles travaillent comme un seul cerveau géant. C'est une brigade entière qui cuisine le même plat en parfaite synchronisation."

3. Le Stockage Haute Performance : Le Garde-Manger Géant

Sophie intervint :

— "Le problème, c'est aussi l'accès aux fichiers. Quand le modèle cherche une image, ça rame."

Claire dessina un immense frigo.

— "Exactement. L'IA est affamée de données (Data Hungry). Si le chef doit courir à la cave chercher chaque ingrédient, il perd du temps. Il nous faut du Stockage Haute Performance."

Capacité : "On doit pouvoir stocker des pétaoctets (texte, images, code)."

Vitesse (Throughput) : "Le débit est crucial. Il faut que les données arrivent dans la poêle du chef instantanément. Pas de temps de latence en lecture/écriture."

4. Le Réseau (Networking) : Les Serveurs en Rollers

Enfin, Claire traça des lignes épaisses entre le frigo et les cuisiniers.

— "C'est le dernier goulot d'étranglement : le Réseau. Si on a des super chefs et un super frigo, mais que le couloir est bouché, ça ne sert à rien. Le réseau de fibre optique de Google offre une latence ultra-faible. C'est comme si les serveurs se passaient les plats à la vitesse de la lumière."

Le Quiz de la Réalité

Claire se tourna vers Thomas et Sophie.

— "Donc, pour résumer, à quelle étape de notre développement l'infrastructure a-t-elle failli nous tuer ?"

Thomas réfléchit un instant en regardant le schéma.

— "À l'étape de l'Entraînement du Modèle (Model Training). C'est là qu'on a besoin de la force brute."

— "Exactement," valida Claire. "Mais attention, on en aura aussi besoin pour le Déploiement. Si demain 10 000 clients interrogent notre IA en même temps, il faudra que l'infrastructure tienne la charge (Scaling)."

L'équipe IT lança la migration des données vers Google Cloud Storage et configura une instance Vertex AI utilisant des TPUs v4.

L'équipe IT lança la migration des données vers Google Cloud Storage et configura une instance Vertex AI utilisant des TPUs v4.

Le résultat ne se fit pas attendre. Le lundi matin, Sophie revint voir Claire, un grand sourire aux lèvres.

— "C'est terminé. L'entraînement a pris 4 heures au lieu de 3 semaines. Le modèle est prêt à être testé."

Claire avait résolu le problème de la fondation. Elle avait compris que l'IA n'était pas qu'une question de logiciel, mais une question de plomberie lourde, de puces spécialisées et de câbles optiques.

Cependant, alors qu'elle savourait cette victoire, une nouvelle contrainte apparut. Le responsable de la maintenance, qui travaillait souvent dans des zones sans réseau internet (tunnels, sous-sols), vint toquer à sa porte.

— "Claire, ton IA surpuissante dans le Cloud, c'est génial. Mais mes gars, au fond de la mine, ils n'ont pas de Wi-Fi. Ton super-cerveau ne sert à rien s'il est inaccessible."

Claire réalisa qu'elle avait construit une centrale nucléaire, mais qu'elle devait maintenant trouver un moyen de mettre cette énergie dans une pile. Il était temps de découvrir comment faire sortir l'IA du Cloud pour l'amener sur le terrain : c'était l'heure de l'IA en Périphérie (Edge AI).

Voici la suite de l'histoire, où Claire découvre que la puissance brute du Cloud a une faiblesse majeure : la distance.

Quand le Nuage ne suffit plus : L'Intelligence "du Bord"

Le lundi suivant, Claire descendit au niveau -3 du bâtiment logistique, accompagnée de Franck, le chef de la maintenance. L'endroit était un labyrinthe de tuyaux et de machines bruyantes, éclairé par des néons vacillants. Ici, le béton armé bloquait tout : pas de 4G, pas de Wi-Fi.

Franck s'arrêta devant une énorme turbine qui émettait un sifflement inquiétant. Il sortit sa tablette durcie dernier cri, censée être connectée à la nouvelle IA de maintenance.

— "Regarde ça, Claire," dit-il en pointant la tablette vers la machine. "J'ai besoin de savoir si cette vibration est normale ou si ça va exploser. Je lance l'analyse vidéo."

Il appuya sur le bouton. Une roue de chargement apparut. Elle tourna. Une seconde. Cinq secondes. Dix secondes.

— "Tu vois ?" hurla Franck. "Ton IA dans le Cloud, elle est super intelligente, mais elle est sourde et muette ici ! Si une valve lâche, je n'ai pas le temps d'attendre que l'information fasse l'aller-retour jusqu'au data center de Google en Belgique !"

Claire comprit le danger. La latence (le délai de réponse) n'était pas juste agaçante, elle était dangereuse. Le "Cerveau" était trop loin du "Bras".

— "Tu as raison Franck. On ne peut pas dépendre d'Internet pour des décisions vitales à la seconde près. Il faut qu'on descende l'intelligence ici, directement dans ta main."

Le Cloud vs L'Edge : La Grande Bibliothèque et le Guide de Survie

Remontée à la surface avec Franck (et ayant retrouvé du réseau), Claire lui expliqua le changement de stratégie. Elle dessina deux schémas sur un carnet.

Le Cloud (Ce qu'on a fait jusqu'ici) :

— "C'est comme la Grande Bibliothèque Nationale. Elle contient tout le savoir du monde (les gros modèles). Mais si tu as une urgence dans la jungle, tu ne peux pas appeler le bibliothécaire à chaque fois."

L'Edge Computing (L'Informatique en périphérie) :

— "C'est le Guide de Survie que tu as dans ta poche. Il est plus petit, il en sait moins sur la poésie du 18ème siècle, mais il sait comment faire un garrot ou réparer un moteur immédiatement, sans demander à personne."

Shutterstock

— "L'Edge Computing," définit Claire, "c'est faire tourner l'IA directement sur l'appareil (la source de la donnée), au lieu de l'envoyer sur un serveur lointain."

Gemini Nano et LiteRT : La puissance en format poche

Franck semblait intéressé mais dubitatif.

— "Mais Claire, tu m'as dit qu'il fallait des super-calculateurs pour faire tourner l'IA. Ma tablette ne va pas fondre ?"

— "Non, car Google a créé des versions miniatures de ses cerveaux," répondit Claire.

Elle lui présenta deux technologies clés :

Gemini Nano : "C'est le petit frère de Gemini. C'est le modèle le plus efficace et compact. Il est conçu pour vivre dans ton téléphone ou ta tablette Pixel. Il n'a pas besoin d'internet. Il est autonome."

LiteRT (Lite Runtime) : "C'est l'adaptateur. C'est le logiciel qui optimise le modèle pour qu'il tourne sur la petite puce de ta tablette sans vider la batterie en dix minutes."

— "Avec Gemini Nano installé sur ta tablette," promit Claire, "tu pourras scanner ta turbine au sous-sol. L'IA analysera le son et l'image localement. Zéro latence. Confidentialité totale (les données ne sortent pas du sous-sol)."

Le Workflow Vertex AI : L'Usine qui fabrique les miniatures

Le lendemain, Claire réunit son équipe IT pour mettre cela en place. Thomas, le développeur, pensait qu'il allait devoir apprendre un nouveau métier.

— "Pas du tout," le rassura Claire. "On utilise toujours Vertex AI comme tour de contrôle."

Elle dessina le processus de déploiement au tableau :

Entraîner (Train) : "On utilise la puissance du Cloud (Vertex AI) pour apprendre à l'IA à reconnaître les pannes de turbines."

Convertir (Convert) : "On utilise les outils Vertex pour compresser ce modèle en format LiteRT."

Empaqueter et Déployer (Package & Deploy) : "On envoie ce petit paquet (Container) directement dans les tablettes de l'équipe de Franck."

Surveiller (Monitor) : "Quand les tablettes se reconnectent au Wi-Fi le soir, elles nous envoient des rapports de performance."

Le Quiz Décisionnel : Où mettre l'intelligence ?

Pour être sûre que son équipe sache choisir entre Cloud et Edge à l'avenir, Claire organisa un vote à main levée sur quatre scénarios concrets de l'entreprise.

— "Allez, on vote : Cloud (Cerveau central) ou Edge (Cerveau local) ?"

Scénario A : Le Robot Chirurgien.

Le projet de bras robotisé pour assister des opérations délicates.

— Réponse : Edge ! "On ne peut pas avoir de latence (lag) quand on opère un patient. La décision doit être instantanée."

Scénario B : Le Chatbot Service Client.

Gérer 10 000 requêtes clients par jour sur le site web.

— Réponse : Cloud ! "On a besoin d'une puissance massive et scalable pour répondre à tout le monde en même temps."

Scénario C : La Voiture Autonome de livraison.

Elle traverse un passage piéton et un enfant surgit.

— Réponse : Edge ! "La voiture doit freiner en millisecondes. Elle ne peut pas attendre que le serveur lui dise 'Stop'."

Scénario D : L'Optimisation du trafic urbain.

Analyser les flux de toute la ville pour régler les feux rouges.

— Réponse : Cloud ! "C'est une vue d'ensemble qui demande d'agréger des milliers de données."

Conclusion : La boucle est bouclée (ou presque)

Franck repartit avec sa tablette mise à jour, équipée de Gemini Nano. Le test fut concluant : au fond du sous-sol, sans une barre de réseau, l'IA diagnostiqua une usure de roulement en 0,2 seconde.

Claire regarda sa pyramide technologique. Elle avait l'Infrastructure, les Modèles, la Plateforme, les Agents, et maintenant, elle savait comment déployer tout ça, du Cloud infini jusqu'à la poche de ses employés.

Son système était puissant. Il était rapide. Il était omniprésent.

Mais alors qu'elle célébrait ce succès technique, une notification sur son téléphone la glaça. C'était un email du département Juridique, avec un objet en majuscules rouges : "URGENT : BIAIS DISCRIMINATOIRE DÉTECTÉ DANS L'AGENT RH".

Claire réalisa qu'elle avait construit une machine ultra-performante, mais elle avait oublié de vérifier si cette machine avait une "conscience". Il était temps d'aborder le sujet le plus critique de tous : l'IA Responsable.

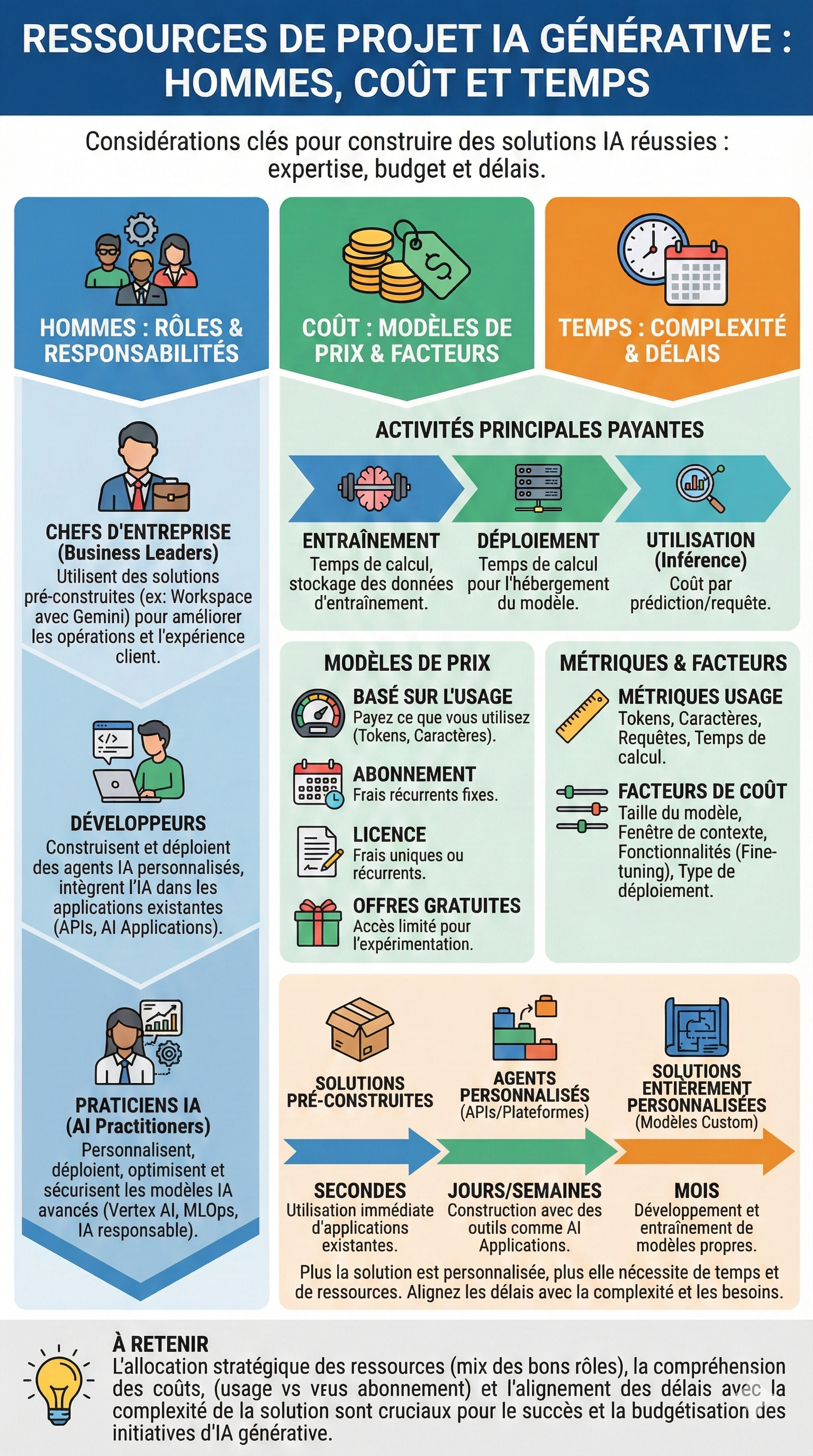

La Facture Douloureuse : Quand le "Fait-Maison" coûte trop cher

Le lundi matin, l’ambiance dans la salle de réunion du comité de direction était électrique. Marc, le Directeur Financier, venait de projeter un tableau Excel sur l'écran géant. Les chiffres étaient en rouge vif.

— "Quelqu'un peut m'expliquer pourquoi le projet 'Marketing-Bot' a consommé 40% de son budget annuel en... trois semaines ?" aboya Marc, en tapotant nerveusement son stylo sur la table. "Et le pire, c'est que Sophie me dit que l'outil ne marche toujours pas !"

Sophie, la Directrice Marketing, leva les bras au ciel.

— "Je n'y peux rien ! J'ai demandé à l'IT un outil pour générer des posts LinkedIn et résumer nos rapports de tendances. Thomas m'a dit qu'il devait 'entraîner le modèle'. J'attends toujours."

Thomas, le Lead Développeur, semblait acculé.

— "C'est normal, Marc. On entraîne un LLM open-source sur nos serveurs. Ça prend du temps et de la puissance de calcul. On fait du sur-mesure !"

Claire, qui observait la scène, comprit immédiatement l'erreur. Ils étaient en train de construire une centrale nucléaire pour allumer une ampoule. Ils avaient mal évalué les trois piliers d'un projet IA : Les Hommes, le Coût et le Temps.

Elle se leva.

— "On arrête l'hémorragie. Marc, éteins ton Excel. Thomas, arrête tes serveurs. On a un problème d'alignement."

1. Les Hommes : Qui fait quoi dans la cuisine ?

Claire dessina trois toques de cuisine au tableau.

— "Le problème, c'est que vous jouez tous le mauvais rôle. Thomas, tu essaies d'être un Chimiste du goût alors que tu es un Chef Cuisinier."

Elle expliqua la pyramide des compétences nécessaire pour un projet IA :

Les Business Leaders (Sophie) : "Toi, tu es le client du restaurant. Tu veux manger (utiliser l'IA) pour améliorer ton quotidien (Productivité). Tu n'as pas besoin de savoir comment le four fonctionne. Pour tes résumés et tes emails, un outil 'clé en main' comme Gemini pour Workspace suffit. Tu n'as pas besoin de développement."

Les Développeurs (Thomas) : "Toi, tu es le Cuisinier. Ton job est d'assembler des ingrédients existants. Tu utilises des APIs, tu connectes l'IA à nos bases de données via Vertex AI. Tu construis l'application, l'agent. Mais tu n'es pas censé fabriquer la farine toi-même !"

Les AI Practitioners (Le profil manquant) : "Ce que tu essaies de faire, Thomas (entraîner un modèle brut, gérer les hyperparamètres), c'est le travail d'un Praticien IA. C'est le Chimiste. On a besoin d'eux seulement si on doit inventer un nouveau modèle ou le modifier en profondeur. Pour 90% de nos besoins, on n'en a pas besoin."

Thomas baissa les yeux.

— "Je voulais bien faire. Je pensais qu'il fallait tout construire nous-mêmes."

2. Le Temps : Le dilemme du "Buy vs Build"

Claire traça ensuite une ligne temporelle.

— "Thomas, en voulant jouer au Praticien IA, tu as explosé les délais."

Elle nota trois options sur la ligne :

Utiliser une App existante (Ex: Gemini Advanced) :

Temps : Immédiat.

Usage : Pour Sophie qui veut résumer un PDF.

Construire un Agent avec des APIs (Ex: AI Applications) :

Temps : Quelques jours/semaines.

Usage : Pour connecter l'IA à notre base de données produits.

Construire une solution Custom (Ce que Thomas a fait) :

Temps : Des mois.

Usage : Nécessaire uniquement si notre besoin est unique au monde.

— "Sophie a besoin d'un outil maintenant. Pas dans six mois," trancha Claire.

3. Le Coût : Comprendre la facture du Taxi

Marc, le financier, n'était toujours pas calmé.

— "D'accord pour les délais. Mais pourquoi la facture est-elle si variable ? Un coup c'est cher, un coup c'est très cher."

Claire sourit. C'était la partie la plus complexe à expliquer aux financiers.

— "Marc, l'IA ne se facture pas comme une licence logicielle classique (un prix fixe par an). C'est comme un Taxi."

Elle dessina un compteur de taxi.

— "Il y a trois moments où tu payes :"

L'Entraînement (Training) : "C'est ce que Thomas a fait. C'est comme acheter la voiture. Ça coûte une fortune en investissement initial (Compute & Storage)."

Le Déploiement (Hosting) : "C'est louer le garage. Même si personne n'utilise l'IA, si le serveur tourne, on paye."

L'Inférence (Prediction) : "C'est rouler avec la voiture. C'est là que le modèle 'Pay-as-you-go' intervient."

Elle détailla les métriques de facturation à l'usage (Usage-based) :

Les Tokens / Caractères : "Google (et les autres) facturent souvent au kilomètre. Dans le monde de l'IA, le kilomètre, c'est le Token (environ 3/4 d'un mot) ou le Caractère. Plus Sophie est bavarde avec le chatbot, plus le compteur tourne."

La Fenêtre de Contexte : "Si Sophie envoie un livre entier de 500 pages à analyser, c'est un trajet très long. Ça coûte plus cher qu'une simple question."

Le Plan de Sauvetage

Claire effaça le tableau et écrivit le nouveau plan de bataille.

— "On change de stratégie pour respecter le budget et les délais :"

Pour Sophie (Immédiat) : "On prend des licences Workspace avec Gemini. Coût fixe (Abonnement), mise en place immédiate. Problème résolu."

Pour l'outil interne (Moyen terme) : "Thomas, tu arrêtes l'entraînement. Tu vas utiliser Vertex AI et les modèles pré-entraînés (APIs). Tu vas payer à la requête (Usage-based), ce qui coûtera 100 fois moins cher que de faire tourner tes propres serveurs H24."

Surveillance : "Marc, on va mettre des quotas sur le nombre de requêtes pour éviter que le 'compteur du taxi' ne s'emballe."

Marc hocha la tête, rassuré. Thomas semblait soulagé d'être déchargé de la lourdeur de l'infrastructure.

Claire avait remis le train sur les rails. Elle avait affecté les bonnes personnes aux bonnes tâches et choisi le modèle économique adapté.

Mais alors que la réunion se terminait, Sophie posa une dernière question innocente :

— "Super ! Donc dès demain, je peux mettre toutes les données clients et nos secrets de fabrication dans Gemini pour qu'il m'aide à travailler ?"

Claire et le responsable juridique se regardèrent, horrifiés. Ils avaient réglé la technique et le budget, mais ils avaient oublié le garde-fou le plus important.

— "Attends Sophie !" s'écria Claire. "Avant de nourrir l'IA, il faut qu'on parle de ce qu'elle a le droit de manger et de dire."

C'était l'heure de plonger dans le sujet vital de l'IA Responsable.

Le "Titanic" Numérique : L'art de définir le besoin

Mardi, 14h00. La grande salle de conférence "Innovation" était pleine à craquer. Maxime, un chef de projet brillant mais parfois trop enthousiaste, présentait le nouveau "Projet Phare" de l'entreprise : Omni-Brain.

— "C'est une révolution," déclama Maxime. "Nous avons entraîné notre propre modèle de langage à partir de zéro. Il peut tout faire : répondre aux clients, aider les RH, écrire du code, et même prédire la météo de la cafétéria. C'est une IA souveraine hébergée sur nos serveurs !"

Il lança la démo.

Il tapa : "Quel est le solde de congés de Martin ?"

L'écran afficha une roue de chargement.

5 secondes.

10 secondes.

20 secondes.

Le PDG tapota sa montre.

30 secondes plus tard, la réponse s'afficha : "Selon la théorie de la relativité, le temps est une notion flexible. Martin aime les vacances."

Un silence gêné envahit la salle. Martin des RH devint livide : "Attends, il a accès à mes dossiers personnels ? Et pourquoi il raconte n'importe quoi ?"

Le Directeur Commercial ajouta : "Si ça met 30 secondes pour répondre à un client, on va tous faire faillite."

Le "Titanic" venait de heurter l'iceberg. Maxime avait construit une usine à gaz ingérable.

Claire se leva. Elle ne voulait pas humilier Maxime, mais il fallait sauver le budget (et la réputation de l'IA).

— "Maxime, l'ambition est superbe. Mais je crois qu'on a essayé de construire un couteau suisse pour couper un steak, et qu'on se retrouve avec une tronçonneuse qui n'a plus d'essence. On a sauté l'étape cruciale de l'évaluation des besoins."

Elle alla au tableau blanc.

— "Avant de coder la moindre ligne, on doit passer ton projet au scanner des 5 Facteurs de Faisabilité."

1. L'Échelle (Scale) : Food Truck ou Multinationale ?

Claire dessina une petite camionnette et un immense gratte-ciel.

— "Maxime, tu as dimensionné ton projet pour qui ?"

— "Pour tout le monde ! Les 50 employés du siège et nos 2 millions de clients web," répondit fièrement Maxime.

— "C'est là le premier piège," expliqua Claire. "On ne construit pas la même chose pour une équipe que pour le monde entier."

Petite Échelle (Small Scale) : "Pour les 50 employés du siège, on n'a pas besoin de développer un monstre. On utilise des outils pré-construits (Pre-built tools) comme Gemini dans Workspace. C'est le Food Truck : rapide, efficace, prêt à servir."

Grande Échelle (Large Scale) : "Pour les 2 millions de clients, là, il faut du robuste, du sécurisé, et surtout, surveiller les coûts d'infrastructure. Si ton modèle coûte 0,10€ par requête et que tu as un million de requêtes, on ferme l'entreprise demain."

2. La Customisation : Prêt-à-porter ou Haute Couture ?

Claire continua son audit.

— "Tu as dit avoir entraîné un modèle 'from scratch' (à partir de zéro). Pourquoi ?"

— "Pour qu'il soit précis !"

— "C'est comme tisser son propre coton pour faire un t-shirt," rétorqua gentiment Claire. "C'est long et cher."

Elle lista la hiérarchie du besoin :

Commencer par l'existant : "Les modèles de fondation (Gemini, PaLM) sont déjà des génies. Utilisons-les via API."

Identifier l'unique : "Est-ce qu'on a besoin de connaissances ultra-spécifiques (Droit, Médecine) ? Si oui, on fait du Fine-tuning (ajustement) sur nos données. Sinon, le modèle de base suffit."

Complexité de la tâche : "Pour résumer des emails, un petit modèle suffit. Pour générer du code complexe, il faut un gros modèle."

3. L'Expérience Utilisateur (UI/UX) : Le Cockpit

— "Ensuite," poursuivit Claire en pointant l'écran qui affichait toujours la réponse absurde sur la relativité, "comment l'utilisateur interagit ?"

— "Bah, une boîte de chat," dit Maxime.

— "Ce n'est pas suffisant. L'intégration doit être Fluide (Seamless)."

UI (Interface) : "Le commercial veut l'info dans son CRM, pas dans une fenêtre à part."

UX (Expérience) : "Est-ce que l'IA doit être bavarde ou aller droit au but ? Ici, pour les congés, on voulait un chiffre, pas de la philosophie."

4. La Confidentialité (Privacy) : Le Coffre-Fort

Martin des RH leva la main, toujours inquiet. "Et mes données ?"

Claire dessina un cadenas rouge.

— "C'est le point critique. Maxime, as-tu vérifié la Compliance (RGPD) ?"

Maxime devint pâle. "Euh..."

— "Si on traite des données sensibles (Santé, Finance, RH), la sécurité n'est pas une option. On doit chiffrer, contrôler les accès, et parfois utiliser des modèles privés qui ne partagent rien avec l'extérieur."

5. Les "Oubliés" techniques : Latence, Connexion, Précision

Enfin, Claire nota trois mots en bas du tableau, ceux qui tuent souvent les projets dans l'œuf.

Latence (Le Chronomètre) :

"Ton modèle a mis 30 secondes. C'est inacceptable pour du temps réel. Si l'interaction n'est pas critique, on peut tolérer du délai. Mais pour un chatbot client, ça doit être instantané."

Connectivité (Le Tunnel) :

"Nos commerciaux vont dans des sous-sols. Ton IA a-t-elle besoin d'internet tout le temps ? Si oui, il faut prévoir un mode hors-ligne ou de l'Edge AI."

Explicabilité (Le "Pourquoi") :

Elle se tourna vers Marc, le financier. "Marc, si l'IA refuse un crédit à un client, peux-tu dire pourquoi ?"

Marc secoua la tête. "Si je ne peux pas expliquer la décision à l'auditeur, je vais en prison."

— "Exactement. Dans la finance ou la santé, la transparence est clé. On ne peut pas utiliser une 'boîte noire'."

Le Verdict

Claire posa le feutre. Le diagnostic était clair : Omni-Brain était trop gros, trop lent, et potentiellement illégal.

— "Voici ma proposition," conclut Claire. "On démantèle Omni-Brain. On le remplace par trois projets ciblés :"

Un Agent RH interne sur Gemini Enterprise (Sécurisé, rapide).

Un Chatbot Client léger basé sur une API publique (Scalable).

Un Assistant Financier avec une forte explicabilité pour Marc.

La salle respira. Maxime, bien que déçu pour son "bébé", réalisa qu'il venait d'éviter une catastrophe industrielle.

La réunion se termina sur un sentiment de soulagement. Claire avait remis de l'ordre en alignant la technologie sur les besoins réels du business.

Cependant, alors qu'elle rangeait ses affaires, Claire reçut une notification sur son téléphone. C'était un article de presse envoyé par son frère : "Scandale : Une IA générative conseille à un utilisateur de manger des cailloux pour digérer."

Claire se figea. Elle avait défini les besoins techniques et fonctionnels. Mais elle avait oublié une dimension essentielle. Même si l'IA est rapide, pas chère et sécurisée... comment s'assurer qu'elle ne devient pas toxique, biaisée ou dangereuse ?

Il était temps d'ouvrir le dossier le plus délicat de sa formation : l'IA Responsable.

Voici la suite de l'histoire, où Claire apprend à son équipe que "lancer" un projet n'est que le début du voyage.

L'Effet "Tamagotchi" : Survivre après le lancement

Six mois. C'était le temps écoulé depuis le déploiement triomphal de "SalesGenius", l'IA générative censée aider l'équipe commerciale à rédiger des propositions complexes. Au début, c'était l'euphorie : gain de temps, propositions percutantes, bonus pour tout le monde.

Mais ce lundi matin, l'ambiance dans le bureau de Jérôme, le Directeur Commercial, était funèbre.

— "C'est fini, Claire. Je désactive ton outil," lâcha Jérôme en jetant une liasse de papiers sur la table.

— "Quoi ? Mais les chiffres étaient excellents !" s'étonna Claire.

— "Étaient. Regarde la dernière proposition envoyée au client BigCorp. L'IA a cité des prix de 2023. Elle a inclus une gamme de produits qu'on a arrêtée le mois dernier. Et pire, elle a inventé une remise de 25% qui n'existe pas dans nos conditions générales."

Thomas, le Lead Développeur, était assis dans un coin, l'air coupable.

— "Je ne comprends pas," murmura-t-il. "Le code n'a pas changé. C'est le même modèle qu'au premier jour."

Claire réalisa soudain l'erreur fondamentale. Ils avaient traité l'IA comme un logiciel classique (qu'on installe et qu'on oublie) alors que c'est une matière vivante.

— "C'est exactement le problème, Thomas," dit Claire. "Le code n'a pas changé, mais le monde, lui, a changé. On a acheté une plante verte, et on a oublié de l'arroser pendant six mois. Elle est en train de mourir."

Elle se leva pour prendre le contrôle de la situation.

— "Jérôme, ne coupe rien. Laisse-nous 24 heures. On va passer du mode 'Lancement' au mode 'Jardinage'."

1. Le Casting : Choisir le bon acteur pour le bon rôle

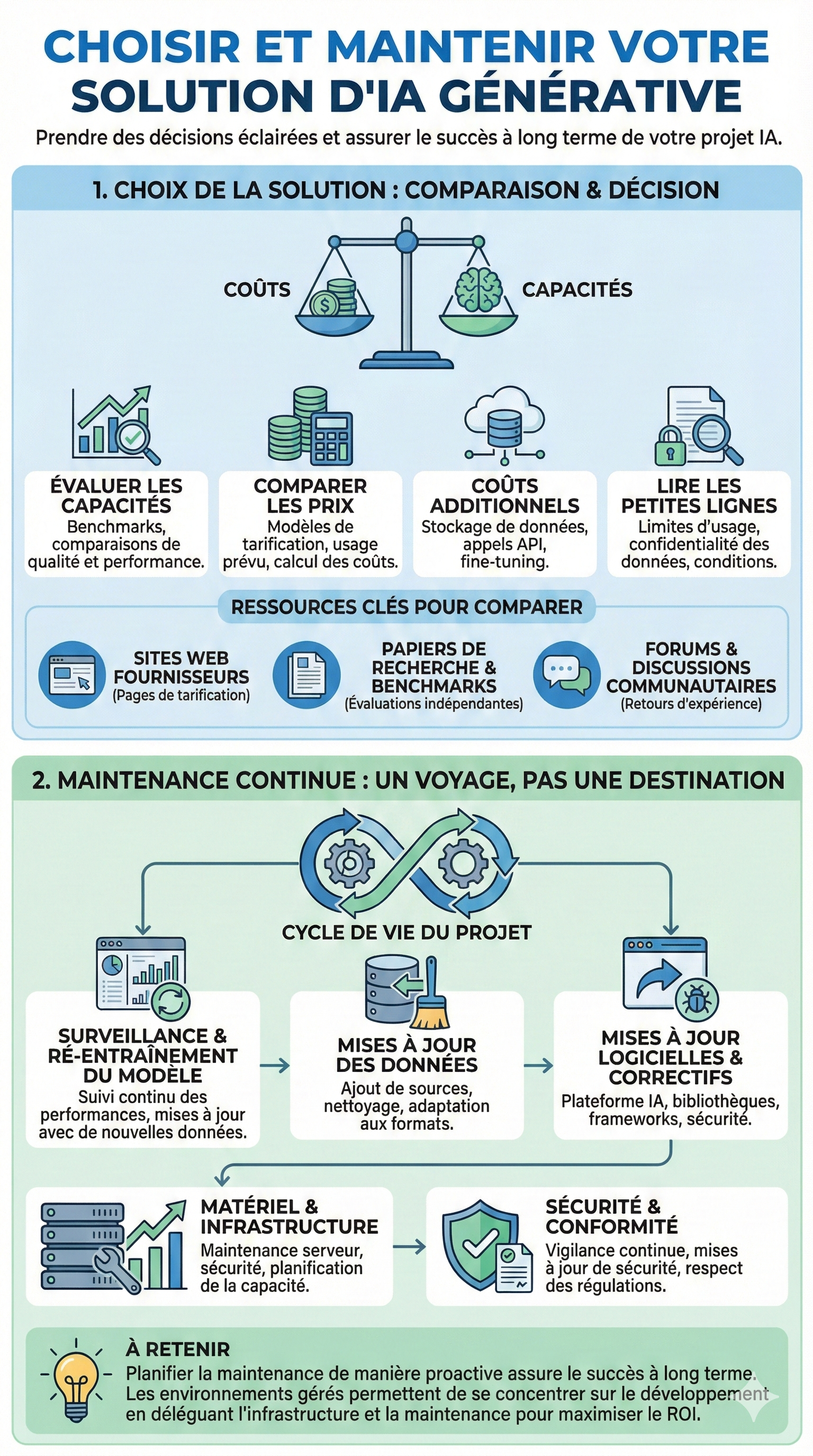

Pour comprendre comment ils en étaient arrivés là, Claire réunit l'équipe projet. Il fallait d'abord vérifier si le modèle utilisé à la base était toujours le bon.

— "Thomas, pourquoi avons-nous choisi ce modèle spécifique au début ?" demanda Claire.

— "C'était le plus hype sur Twitter à l'époque," avoua Thomas.

Claire soupira. Elle dessina un tableau comparatif au tableau blanc.

— "On ne recrute pas un Directeur Financier parce qu'il est populaire sur TikTok. On doit faire un Casting Rigoureux."

Elle lista les critères qu'ils auraient dû (et devront désormais) surveiller pour choisir ou changer de modèle :

Capacités (Le CV) : "Regardez les Benchmarks (tests standardisés). Est-ce que ce modèle est vraiment bon en calcul mathématique pour nos devis ? Ou est-il juste bon en poésie ?"

Structure de Prix (Le Salaire) : "Est-ce qu'on paye au mot (Token) ? À l'abonnement ? Pour SalesGenius, on génère des documents longs. Un modèle facturé au caractère peut nous ruiner."

Coûts Cachés (Les notes de frais) : "Attention aux frais annexes : le stockage des données, les appels API, et le coût du Fine-tuning."

Les "Petites Lignes" (Le Contrat) : "Thomas, as-tu lu la politique de confidentialité ? Si nos données partent entraîner le modèle public d'un concurrent, on est morts."

— "Pour comparer," ajouta-t-elle, "n'écoutez pas juste les vendeurs. Allez sur les forums communautaires, lisez les papiers de recherche indépendants."

2. La Maintenance : Ne pas laisser mourir le Tamagotchi

Une fois le choix du modèle validé (ils décidèrent de passer sur une version plus récente et moins chère de Gemini), il restait le problème de fond : l'obsolescence des données.

Claire utilisa une métaphore qui parla à toute la génération de Thomas.

— "Vous vous souvenez des Tamagotchis ? Ces petits animaux virtuels qu'il fallait nourrir tous les jours sinon ils mourraient ?"

L'équipe hocha la tête.

— "Une IA Générative, c'est un Tamagotchi de luxe. Ce n'est pas une destination, c'est un voyage. Si vous arrêtez de vous en occuper après le lancement, elle dépérit."

Elle traça le plan de maintenance vitale (Lifecycle Management) :

A. Le Bilan de Santé (Monitoring)

— "On ne peut pas attendre que Jérôme vienne hurler pour savoir que l'IA déraille. Il nous faut des sondes."

Action : Mettre en place des alertes automatiques si le modèle commence à halluciner ou si les utilisateurs notent mal les réponses.

B. La Nourriture Fraîche (Data Updates)

— "L'IA a proposé des produits obsolètes à BigCorp parce qu'elle ne savait pas qu'ils n'existaient plus."

Action : Connecter l'IA en temps réel à la base de données produits (Grounding), ou prévoir un ré-entraînement mensuel avec les nouvelles grilles tarifaires.

C. Les Vaccins (Security & Compliance)

— "Les régulations changent. Les failles de sécurité évoluent."

Action : Auditer la sécurité tous les trimestres. Vérifier que l'IA ne révèle pas de données personnelles par inadvertance.

L'Avantage du "Full Service"

Thomas semblait accablé par la charge de travail.

— "Claire, je suis développeur, pas jardinier ni vétérinaire. Je n'ai pas le temps de gérer les serveurs, les mises à jour de sécurité, le monitoring..."

Claire sourit. C'était l'argument massue pour l'utilisation d'une plateforme gérée.

— "C'est pour ça qu'on utilise Google Cloud et Vertex AI. C'est un environnement entièrement géré."

Elle expliqua :

— "Imagine que tu loues un appartement dans un hôtel de luxe :"

Tu n'as pas à réparer la plomberie (Infrastructure & Hardware).

Tu n'as pas à changer les serrures (Sécurité).

Tu n'as pas à faire le ménage (Mises à jour logicielles).

— "Google s'occupe de maintenir l'hôtel (la plateforme). Toi, Thomas, tu te concentres uniquement sur la décoration de la chambre (le développement de l'Agent)."

Le plan de maintenance fut validé. Jérôme accepta de redonner sa chance à SalesGenius, rassuré par le fait que l'IA serait désormais "mise à jour" chaque semaine avec les nouveaux tarifs.

Claire avait sauvé le projet en changeant la mentalité de l'équipe : ils n'étaient plus des constructeurs de logiciels, mais des gestionnaires de cycle de vie.

Cependant, alors qu'elle quittait le bureau tard ce soir-là, une pensée la traversa. Ils avaient sécurisé la technique, le coût, et la maintenance. L'IA était performante et à jour. Mais dans la dernière proposition générée, l'IA avait utilisé un ton très agressif pour négocier, imitant sans le vouloir les emails d'un ancien directeur commercial toxique dont les archives avaient servi à l'entraînement.

Claire réalisa qu'une IA bien entretenue pouvait quand même être malpolie, biaisée, voire éthiquement douteuse.

Il était temps d'aborder le dernier pilier, celui qui garantit que la technologie reste au service de l'humain sans le blesser : l'IA Responsable et l'Éthique.